机器学习 lr,二、逻辑回归的原理

LR 是机器学习中的一个重要概念,它代表逻辑回归(Logistic Regression)。逻辑回归是一种核算办法,常用于二分类问题,即猜测成果只要两种或许的状况。LR 的基本思维是经过树立数学模型来描绘自变量与因变量之间的联系,然后完成猜测的意图。

LR 模型的首要特点是运用 Sigmoid 函数作为激活函数,将线性回归模型的输出转换为概率值,然后完成二分类猜测。LR 模型的参数一般经过梯度下降法进行优化,以进步模型的猜测准确性。

LR 模型在许多范畴都有广泛的运用,如垃圾邮件过滤、情感剖析、用户行为猜测等。LR 模型的长处是模型简略、易于完成,而且能够处理非线性联系。可是,LR 模型也有其局限性,如难以处理多分类问题、简略受到过拟合的影响等。

总的来说,LR 是机器学习中的一种重要办法,它经过树立数学模型来完成二分类猜测。LR 模型在许多范畴都有广泛的运用,而且具有模型简略、易于完成等长处。可是,LR 模型也有其局限性,如难以处理多分类问题、简略受到过拟合的影响等。

深化解析机器学习中的逻辑回归(LR)算法

逻辑回归(Logistic Regression,简称LR)是机器学习中一种经典的分类算法,广泛运用于各种分类使命中。虽然其称号中带有“回归”二字,但实践上逻辑回归是一种用于处理二分类问题的核算学习办法。本文将深化解析逻辑回归算法的原理、完成办法以及在实践运用中的优势。

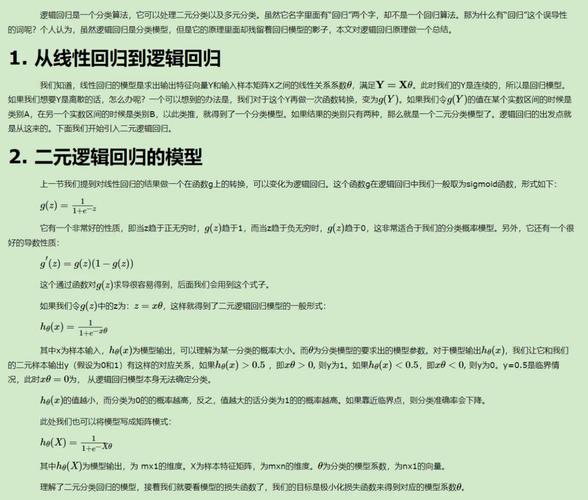

二、逻辑回归的原理

逻辑回归的中心思维是经过一个线性函数的组合,将特征和类别之间的联系建模为一个概率。具体来说,逻辑回归假定数据遵守伯努利分布,经过极大化似然函数的办法,运用梯度下降来求解参数,然后完成将数据二分类的意图。

三、逻辑回归的公式与丢失函数

逻辑回归的公式如下:

\\[ P(Y=1|X) = \\frac{1}{1 e^{-(\\beta_0 \\beta_1X_1 \\beta_2X_2 ... \\beta_nX_n)}} \\]

谈判,\\( P(Y=1|X) \\) 表明在给定特征 \\( X \\) 的状况下,样本归于正类的概率;\\( \\beta_0, \\beta_1, \\beta_2, ..., \\beta_n \\) 为模型参数。

逻辑回归的丢失函数为穿插熵丢失函数(Cross-Entropy Loss),也称为对数丢失(Log Loss),其公式如下:

\\[ L(\\theta) = -\\frac{1}{N} \\sum_{i=1}^{N} [y_i \\log(\\hat{y}_i) (1 - y_i) \\log(1 - \\hat{y}_i)] \\]

四、逻辑回归的完成办法

逻辑回归的完成办法首要绵亘以下过程:

1. 数据预处理:对输入特征进行标准化处理,进步模型练习的功率。

2. 梯度下降法:经过迭代优化模型参数,使得丢失函数最小化。

3. 模型评价:运用穿插验证等办法评价模型功能。

五、逻辑回归在实践运用中的优势

逻辑回归在实践运用中具有以下优势:

1. 简略易完成:逻辑回归算法原理简略,易于了解和完成。

2. 高效:逻辑回归算法核算功率高,适用于大规模数据集。

3. 可解说性强:逻辑回归模型参数具有清晰的物理含义,便于解说。

4. 适用于二分类和多分类问题:逻辑回归不只能够用于二分类问题,还能够经过一些技巧扩展到多分类问题。

六、逻辑回归的局限性

虽然逻辑回归在实践运用中具有许多优势,但也存在一些局限性:

1. 对异常值灵敏:逻辑回归模型对异常值较为灵敏,或许导致模型功能下降。

2. 无法处理非线性联系:逻辑回归模型假定特征与类别之间存在线性联系,无法处理非线性联系。

3. 无法处理高维数据:当特征维度较高时,逻辑回归模型的功能或许会受到影响。

逻辑回归作为一种经典的分类算法,在机器学习中具有广泛的运用。本文深化解析了逻辑回归的原理、完成办法以及在实践运用中的优势与局限性,期望对读者有所协助。

相关

-

机器学习壁纸,科技美学与构思交融的视觉盛宴详细阅读

你能够从以下几个网站下载机器学习壁纸:1.WallpaperAccess:这个网站供给了一组高质量的机器学习4K壁纸,总共有46张,适用于桌面、手机或平板电脑。你能够拜访以...

2024-12-26 0

-

自学习机器人,未来智能日子的推进者详细阅读

自学习机器人是指能够经过本身的经历和环境反应来不断学习和改善其行为的机器人。这种机器人一般具有以下几个特色:1.感知才能:自学习机器人需求具有感知周围环境的才能,包含视觉、听...

2024-12-26 0

-

AI归纳面试,未来招聘的新趋势详细阅读

1.毛遂自荐:问题:请简略介绍一下自己。答复:扼要介绍自己的教育布景、工作经历以及为什么对AI范畴感爱好。能够提及一些详细的技能或项目经历。2.技能问题:...

2024-12-26 0

-

公函写作ai,助力高效工作的智能帮手详细阅读

4.AI资料星简介:AI资料星是一款备受瞩目的AI辅佐公函写作渠道,分为app移动端和pc端,移动端定坐落体系内沟通社区,包括高质量公函写作范文、公务员沟通社区、...

2024-12-26 0

-

ai画师,新时代的构思工作者详细阅读

AI画师是指运用人工智能技能进行绘画发明的一种东西或服务。它们一般经过深度学习算法,特别是生成对立网络(GANs),来生成具有艺术感的图画。AI画师可以依据用户输入的文本描绘、...

2024-12-26 1

-

我在ai,AI技能怎么改动咱们的日子详细阅读

AI技能怎么改动咱们的日子一、AI技能概述人工智能是指派核算机具有人类智能的技能,包含机器学习、深度学习、自然语言处理、核算机视觉等多个范畴。近年来,跟着核算才能的进步和大数据...

2024-12-26 0

-

ai没有归纳决议计划才干,归纳决议计划才干的缺失详细阅读

1.当时的AI技能:现在的AI技能,尤其是深度学习和机器学习,一般在特定使命上表现出色,例如图像辨认、语音辨认和自然语言处理。这些AI体系一般是为特定使命而规划的,并不具有广...

2024-12-26 1

-

ai制图,改造构思表达,重塑视觉艺术详细阅读

AI制图一般指的是运用人工智能技能来辅佐或彻底主动地创立图形、图画或规划。这可以使用于多种场景,如艺术创造、工业规划、修建规划、游戏开发等。AI制图的关键技能包含:1.计算机...

2024-12-26 1

-

《机器学习》,未来智能年代的柱石详细阅读

关于《机器学习》的学习资源、书本引荐和使用范畴,我为你整理了一些信息,期望对你有所协助。书本引荐1.入门书本:《机器学习》(周志华):这本书是机器学习范畴的经典教材...

2024-12-26 1

-

文言机器学习,什么是机器学习?详细阅读

文言机器学习,简略来说,便是用通俗易懂的言语来解说机器学习这一范畴。机器学习是人工智能的一个分支,它使计算机体系能够从数据中学习,并做出决议计划或猜测。下面我将用文言来解说一些...

2024-12-26 1