机器学习可解说性,进步模型透明度和信赖度

1. 特征重要性:确认哪些特征对模型的猜测成果影响最大。

2. 决议计划树可视化:运用决议计划树可视化东西来了解模型的决议计划进程。

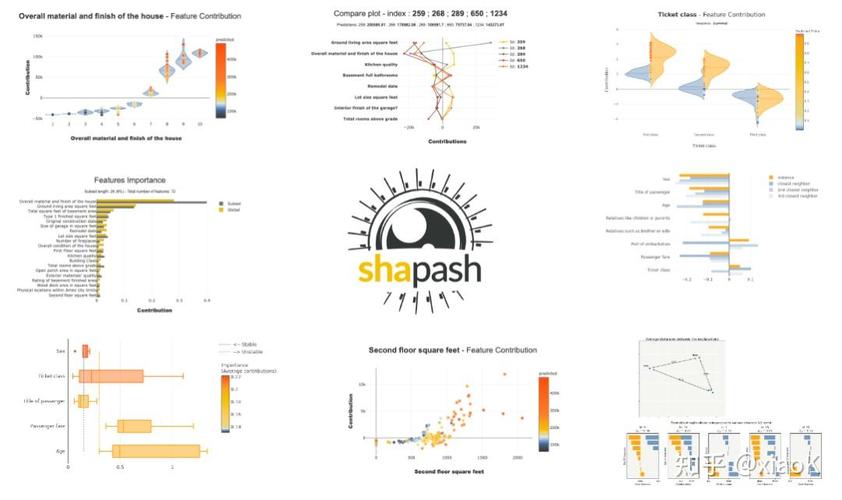

3. 模型解说东西:运用模型解说东西,如LIME和SHAP,来解说模型的猜测成果。

4. 模型简化:经过简化模型来进步可解说性,例如运用决议计划树替代杂乱的神经网络。

5. 特征挑选:挑选与猜测方针最相关的特征,以削减模型杂乱性并进步可解说性。

6. 透明度:供给关于模型练习进程、参数设置和功能指标的信息。

7. 人类可解说性:确保模型解说能够被非专业人士了解。

8. 模型比照:比较不同模型的猜测成果和解说,以挑选最合适的模型。

9. 模型验证:验证模型的猜测成果和解说是否与实践相符。

10. 继续改善:不断搜集用户反应和数据,以改善模型的可解说性。

进步机器学习模型的可解说性有助于进步模型的信赖度、可维护性和改善模型的功能。

机器学习可解说性:进步模型透明度和信赖度

跟着机器学习(ML)技能的飞速开展,其在各个范畴的使用日益广泛。机器学习模型往往被视为“黑盒”,其决议计划进程难以解说,这约束了其在某些要害范畴的使用。因而,机器学习可解说性成为了当时研讨的热门。本文将讨论机器学习可解说性的重要性、应战以及相关技能。

一、机器学习可解说性的重要性

1. 进步模型透明度

机器学习可解说性有助于用户了解模型的决议计划进程,然后进步模型的透明度。这关于需求解说其决议计划的范畴,如医疗确诊、金融风险评价等,尤为重要。

2. 增强用户信赖度

当用户能够了解模型的决议计划进程时,他们更有或许信赖模型的成果。这关于进步机器学习技能在实践使用中的承受度至关重要。

3. 促进模型优化

经过剖析模型的决议计划进程,能够发现模型中的潜在问题,然后促进模型的优化和改善。

二、机器学习可解说性的应战

1. 模型杂乱性

跟着深度学习等杂乱模型的鼓起,模型的决议计划进程愈加难以解说。怎么解说这些杂乱模型成为了可解说性研讨的一大应战。

2. 数据隐私

在处理敏感数据时,怎么在不走漏隐私的前提下解说模型决议计划进程,也是一个重要问题。

3. 核算成本

可解说性技能往往需求额定的核算资源,怎么在确保模型功能的一起下降核算成本,是一个需求处理的问题。

三、机器学习可解说性技能

1. 特征重要性

经过剖析特征对模型输出的影响,能够评价特征的重要性。常用的办法包含特征重要性、Permutation Importance等。

2. 部分可解说性

3. 大局可解说性

大局可解说性技能旨在解说整个模型的决议计划进程。常用的办法包含决议计划树、规矩提取等。

四、未来展望

1. 交融多种可解说性技能

未来研讨能够探究将多种可解说性技能相结合,以更好地解说杂乱模型的决议计划进程。

2. 开展高效的可解说性算法

跟着机器学习模型的不断杂乱化,怎么开发高效的可解说性算法,是一个值得重视的方向。

3. 探究可解说性与隐私维护的结合

在维护数据隐私的前提下,怎么完成模型的可解说性,是一个具有应战性的研讨方向。

经过本文的讨论,咱们能够看到机器学习可解说性在进步模型透明度、增强用户信赖度以及促进模型优化等方面具有重要意义。一起,咱们也认识到机器学习可解说性面临着许多应战。未来,跟着研讨的不断深入,信任机器学习可解说性技能将获得更大的打破。

相关

-

机器学习吴恩达笔记,浅显易懂吴恩达机器学习笔记——敞开AI学习之旅详细阅读

1.知乎专栏:2.CSDN博客:3.GitHub资源:这些资源涵盖了吴恩达机器学习课程的各个章节,包含线性...

2024-12-26 0

-

形式辨认与机器学习,技能交融与未来展望详细阅读

形式辨认与机器学习是两个严密相关但又有差异的范畴。它们都是人工智能的子范畴,致力于让计算机可以从数据中学习并做出决议计划。形式辨认首要重视怎么自动辨认和分类数据中的形式。它一般...

2024-12-26 0

-

机器学习 mobi详细阅读

基本概念机器学习是一门多范畴交叉学科,触及概率论、统计学、迫临论、算法杂乱度理论等多门学科。其主要研讨核算机怎么模仿或完成人类的学习行为,以获取新的常识或技能,重新组织已有的...

2024-12-26 0

-

ai归纳点评办法,全面解析与未来展望详细阅读

1.精确性点评:经过比较AI体系或模型的输出与实在值或专家判别,来点评其精确性。这一般涉及到核算各种目标,如精确率、召回率、F1分数等。2.稳定性点评:点评AI体系或模型在...

2024-12-26 0

-

48ai归纳,探究人工智能在各个范畴的使用与应战详细阅读

PreSonusStudioLive48AIMixSystem是一款功用强壮的48通道数字调音台体系,适用于各种现场表演和专业录音环境。以下是该体系的具体特色:1....

2024-12-26 0

-

机器人课程学习,敞开未来科技之旅详细阅读

机器人课程学习指南1.了解机器人根底常识:机器人分类:了解不同类型的机器人,例如工业机器人、服务机器人、特种机器人等,以及它们的运用范畴。机器人结构:学...

2024-12-26 0

-

ai软件,技能革新与职业运用详细阅读

1.归纳类AI东西:百度文心一言:百度推出的依据文心大模型的AI对话产品,支撑对话互动、问题答复和创造帮忙。阿里通义千问:背靠阿里云强壮的核算才能和数据资源,...

2024-12-26 0

-

ai归纳数据,驱动未来智能开展的中心动力详细阅读

关于AI归纳数据,以下是几份具体的陈述和研讨,供您参阅:1.2024年我国AI根底数据服务研讨陈述:该陈述由我国信息通讯研讨院发布,具体剖析了我国AI根底数据服务商场的...

2024-12-26 0

-

宁波机器人学习,立异驱动下的智能制作新篇章详细阅读

1.宁波中智机器人智能制作训练中心该中心具有工作抢先品牌的机器人自动化设备,供给全面的机器人技能训练。一切训练师资都具有五年以上的项目经历,而且独立承当项目。2.X...

2024-12-26 0

-

机器学习 作业,机器学习作业实践与心得体会详细阅读

1.回归剖析:运用机器学习算法来猜测接连值,例如房价、股票价格或气候温度。2.分类:运用机器学习算法来将数据点分为不同的类别,例如垃圾邮件过滤、图画辨认或情感剖析。3.聚...

2024-12-26 0